OpenAudio (anteriormente Fish-Speech)

Aviso de Licença

Esta base de código é lançada sob a Licença Apache e todos os pesos dos modelos são lançados sob a Licença CC-BY-NC-SA-4.0. Consulte a LICENÇA DO CÓDIGO e a LICENÇA DO MODELO para mais detalhes.

Aviso Legal

Não assumimos nenhuma responsabilidade pelo uso ilegal da base de código. Consulte as leis locais sobre DMCA e outras leis relevantes.

Introdução

Estamos empolgados em anunciar que mudamos nossa marca para OpenAudio - introduzindo uma nova série de modelos avançados de Text-to-Speech que se baseia na fundação do Fish-Speech com melhorias significativas e novas capacidades.

OpenAudio-S1-mini: Blog; Vídeo; Hugging Face;

Fish-Speech v1.5: Vídeo; Hugging Face;

Destaques

Qualidade TTS Excelente

Utilizamos as métricas Seed TTS Eval para avaliar o desempenho do modelo, e os resultados mostram que o OpenAudio S1 alcança 0.008 WER e 0.004 CER em texto inglês, que é significativamente melhor que modelos anteriores. (Inglês, avaliação automática, baseada na transcrição OpenAI gpt-4o, distância do falante usando Revai/pyannote-wespeaker-voxceleb-resnet34-LM)

| Modelo | Taxa de Erro de Palavras (WER) | Taxa de Erro de Caracteres (CER) | Distância do Falante |

|---|---|---|---|

| S1 | 0.008 | 0.004 | 0.332 |

| S1-mini | 0.011 | 0.005 | 0.380 |

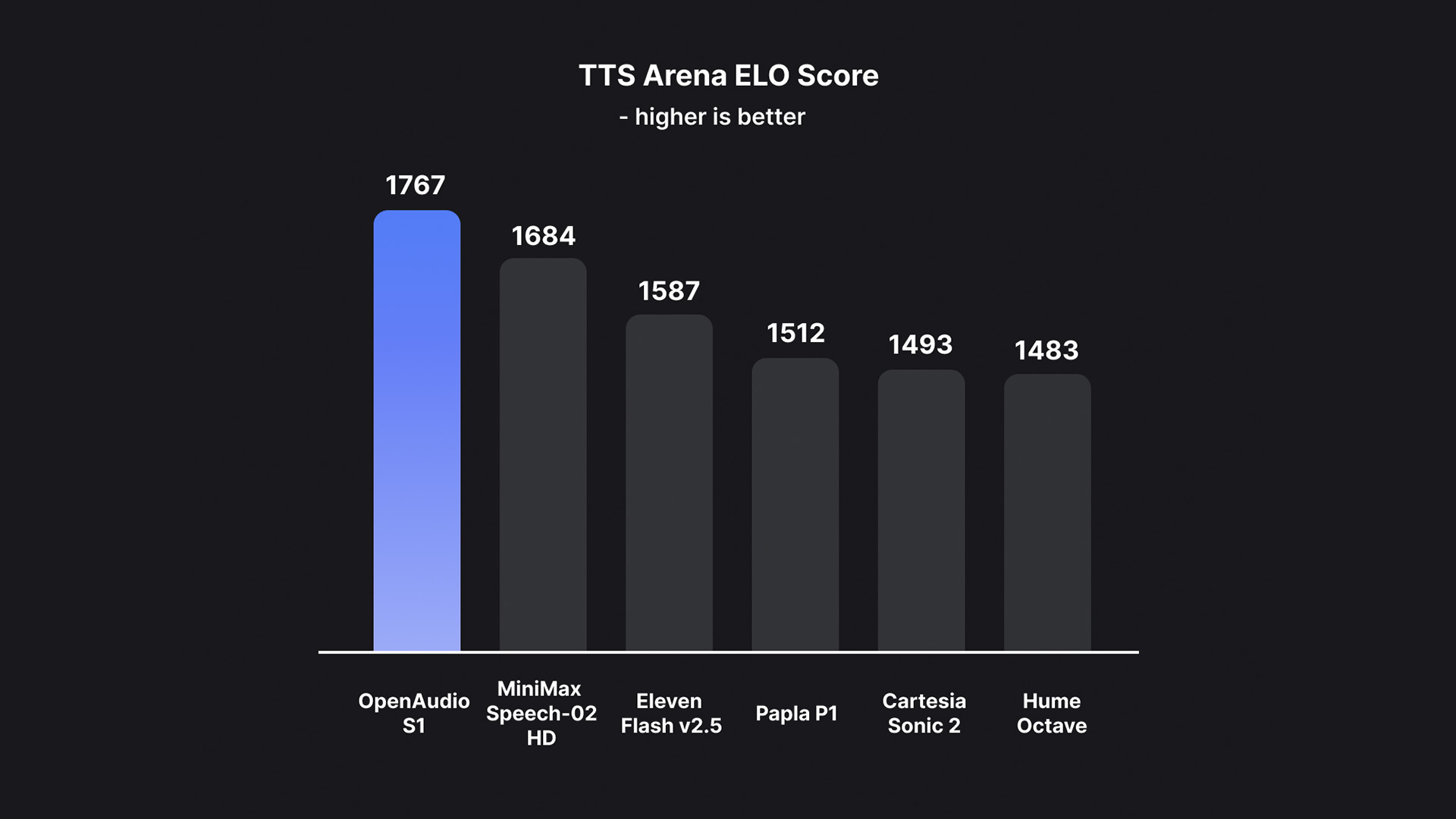

Melhor Modelo no TTS-Arena2

OpenAudio S1 alcançou a classificação #1 no TTS-Arena2, o benchmark para avaliação de text-to-speech:

Controle de Fala

OpenAudio S1 suporta uma variedade de marcadores emocionais, de tom e especiais para aprimorar a síntese de fala:

-

Emoções básicas:

-

Emoções avançadas:

(desdenhoso) (infeliz) (ansioso) (histérico) (indiferente) (impaciente) (culpado) (desprezível) (em pânico) (furioso) (relutante) (entusiasmado) (desaprovador) (negativo) (negando) (espantado) (sério) (sarcástico) (conciliador) (consolador) (sincero) (zombeteiro) (hesitante) (cedendo) (doloroso) (constrangido) (divertido)

(Suporte para inglês, chinês e japonês agora, e mais idiomas em breve!)

-

Marcadores de tom:

-

Efeitos sonoros especiais:

Você também pode usar Ha,ha,ha para controlar, há muitos outros casos esperando para serem explorados por você mesmo.

Dois Tipos de Modelos

Oferecemos duas variantes de modelo para atender diferentes necessidades:

-

OpenAudio S1 (4B parâmetros): Nosso modelo principal com todas as funcionalidades disponível em fish.audio, oferecendo a mais alta qualidade de síntese de fala com todas as características avançadas.

-

OpenAudio S1-mini (0.5B parâmetros): Uma versão destilada com capacidades principais, disponível no Hugging Face Space, otimizada para inferência mais rápida mantendo excelente qualidade.

Tanto o S1 quanto o S1-mini incorporam Aprendizado por Reforço Online com Feedback Humano (RLHF).

Características

-

TTS Zero-shot e Few-shot: Insira uma amostra vocal de 10 a 30 segundos para gerar saída TTS de alta qualidade. Para diretrizes detalhadas, veja Melhores Práticas de Clonagem de Voz.

-

Suporte Multilíngue e Cross-lingual: Simplesmente copie e cole texto multilíngue na caixa de entrada—não precisa se preocupar com o idioma. Atualmente suporta inglês, japonês, coreano, chinês, francês, alemão, árabe e espanhol.

-

Sem Dependência de Fonemas: O modelo tem fortes capacidades de generalização e não depende de fonemas para TTS. Pode lidar com texto em qualquer script de idioma.

-

Altamente Preciso: Alcança uma baixa Taxa de Erro de Caracteres (CER) de cerca de 0,4% e Taxa de Erro de Palavras (WER) de cerca de 0,8% para Seed-TTS Eval.

-

Rápido: Com aceleração fish-tech, o fator de tempo real é aproximadamente 1:5 em um laptop Nvidia RTX 4060 e 1:15 em um Nvidia RTX 4090.

-

Inferência WebUI: Apresenta uma interface web fácil de usar baseada em Gradio, compatível com Chrome, Firefox, Edge e outros navegadores.

-

Inferência GUI: Oferece uma interface gráfica PyQt6 que funciona perfeitamente com o servidor API. Suporta Linux, Windows e macOS. Ver GUI.

-

Amigável para Deploy: Configure facilmente um servidor de inferência com suporte nativo para Linux, Windows (MacOS em breve), minimizando a perda de velocidade.

Mídia e Demos

Mídia Social

Demos Interativos

Showcases em Vídeo

Documentação

Início Rápido

- Configurar Ambiente - Configure seu ambiente de desenvolvimento

- Guia de Inferência - Execute o modelo e gere fala

Comunidade e Suporte

- Discord: Junte-se à nossa comunidade Discord

- Site: Visite OpenAudio.com para as últimas atualizações

- Experimente Online: Fish Audio Playground

Modelos

O OpenAudio S1 é o primeiro modelo da série OpenAudio. É um vocoder VQ-GAN de descodificador duplo que pode reconstruir áudio a partir de códigos VQ.