OpenAudio (구 Fish-Speech)

라이선스 공지

이 코드베이스는 Apache 라이선스에 따라 배포되며, 모든 모델 가중치는 CC-BY-NC-SA-4.0 라이선스에 따라 배포됩니다. 자세한 내용은 코드 라이선스 및 모델 라이선스를 참조하십시오.

법적 면책조항

코드베이스의 불법적인 사용에 대해서는 일체 책임을 지지 않습니다. 귀하의 지역의 DMCA 및 기타 관련 법률을 참고하시기 바랍니다.

소개

저희는 OpenAudio로의 브랜드 변경을 발표하게 되어 기쁩니다. Fish-Speech를 기반으로 하여 상당한 개선과 새로운 기능을 추가한 새로운 고급 텍스트-음성 변환 모델 시리즈를 소개합니다.

Openaudio-S1-mini: 블로그; 동영상; Hugging Face;

Fish-Speech v1.5: 동영상; Hugging Face;

주요 특징

뛰어난 TTS 품질

Seed TTS 평가 지표를 사용하여 모델 성능을 평가한 결과, OpenAudio S1은 영어 텍스트에서 0.008 WER과 0.004 CER을 달성하여 이전 모델보다 현저히 향상되었습니다. (영어, 자동 평가, OpenAI gpt-4o-전사 기반, 화자 거리는 Revai/pyannote-wespeaker-voxceleb-resnet34-LM 사용)

| 모델 | 단어 오류율 (WER) | 문자 오류율 (CER) | 화자 거리 |

|---|---|---|---|

| S1 | 0.008 | 0.004 | 0.332 |

| S1-mini | 0.011 | 0.005 | 0.380 |

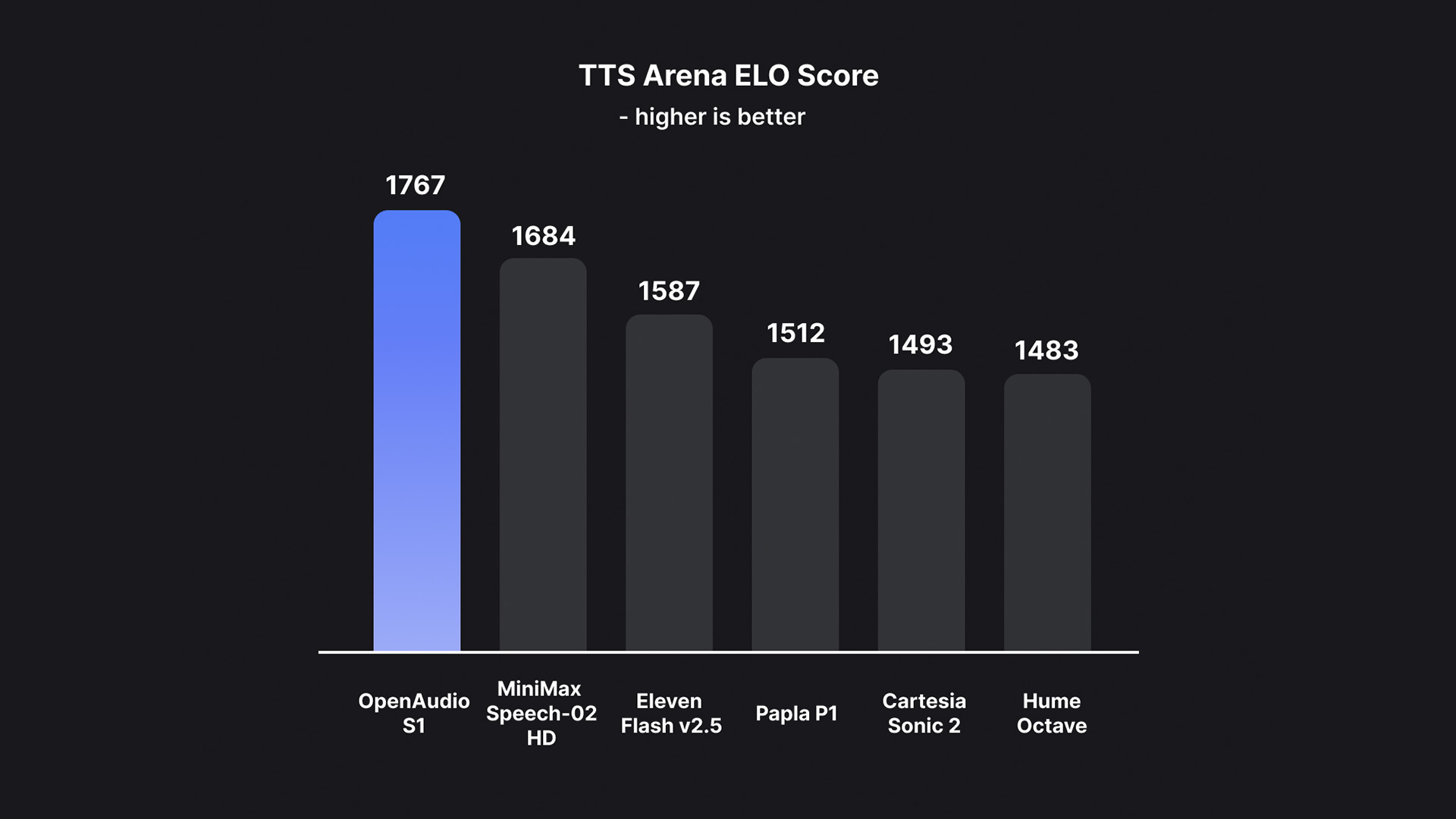

TTS-Arena2 최고 모델

OpenAudio S1은 TTS-Arena2에서 #1 순위를 달성했습니다. 이는 텍스트 음성 변환 평가의 기준입니다:

음성 제어

OpenAudio S1은 다양한 감정, 톤, 특수 마커를 지원하여 음성 합성을 향상시킵니다:

-

기본 감정:

-

고급 감정:

(현재 영어, 중국어, 일본어를 지원하며, 더 많은 언어가 곧 출시될 예정입니다!)

-

톤 마커:

-

특수 음향 효과:

Ha,ha,ha를 사용하여 제어할 수도 있으며, 여러분 스스로 탐구할 수 있는 다른 많은 사용법이 있습니다.

두 가지 모델 유형

S1과 S1-mini 모두 온라인 인간 피드백 강화 학습(RLHF)이 통합되어 있습니다.

기능

-

제로샷 및 퓨샷 TTS: 10~30초의 음성 샘플을 입력하여 고품질 TTS 출력을 생성합니다. 자세한 가이드라인은 음성 복제 모범 사례를 참조하세요.

-

다국어 및 교차 언어 지원: 다국어 텍스트를 입력 상자에 복사하여 붙여넣기만 하면 됩니다. 언어에 대해 걱정할 필요가 없습니다. 현재 영어, 일본어, 한국어, 중국어, 프랑스어, 독일어, 아랍어, 스페인어를 지원합니다.

-

음소 의존성 없음: 이 모델은 강력한 일반화 능력을 가지고 있으며 TTS에 음소에 의존하지 않습니다. 어떤 언어 스크립트의 텍스트도 처리할 수 있습니다.

-

높은 정확도: Seed-TTS Eval에서 약 0.4%의 낮은 문자 오류율(CER)과 약 0.8%의 단어 오류율(WER)을 달성합니다.

-

빠른 속도: torch compile 가속을 통해 Nvidia RTX 4090 실시간 계수 약 1:7.

-

WebUI 추론: Chrome, Firefox, Edge 및 기타 브라우저와 호환되는 사용하기 쉬운 Gradio 기반 웹 UI를 제공합니다.

-

GUI 추론: API 서버와 원활하게 작동하는 PyQt6 그래픽 인터페이스를 제공합니다. Linux, Windows, macOS를 지원합니다. GUI 보기.

-

배포 친화적: Linux, Windows (MacOS 곧 출시 예정)의 네이티브 지원으로 추론 서버를 쉽게 설정하여 속도 손실을 최소화합니다.

미디어 및 데모

소셜 미디어

인터랙티브 데모

동영상 쇼케이스

문서

빠른 시작

커뮤니티 및 지원

- Discord: Discord 커뮤니티에 참여하세요

- 웹사이트: 최신 업데이트는 OpenAudio.com을 방문하세요

- 온라인 체험: Fish Audio Playground